Naupacte était présent avec un intervenant au congrès Simulation numérique de la Société des Ingénieurs de l’Automobile, lors d’une session Data & Optimisation. Ce fut l’occasion de montrer ce qu’on peut attendre en terme d’automatisation des calculs lorsqu’on se lance dans la modélisation et la simulation multiphysiques non-linéaires.

Automatisation des calculs

L’automatisation des calculs entraîne l’optimisation du développeur d’applications, de l’exécution des calculs, ainsi que de l’objet étudié, grâce aux algorithmes de conception optimale.

Le développeur formule son couplage multiphysique, tandis que Navpactos se charge du reste, c’est-à-dire de la construction de la matrice et du second membre obtenus par assemblage éléments finis. Il suffit même de spécifier la construction du second membre, si l’on veut la matrice tangente, car elle s’en déduit par dérivation … par rapport aux degrés de liberté. Navpactos se charge de tout.

Conception optimale automatisée

Navpactos se charge même de plus: des exemples d’optimisation à l’ordre 2, c’est-à-dire reposant sur la jacobienne des équations d’optimalité, i.e. la hessienne du lagrangien, ont été montrés. Par rapport à la programmation du problème direct, il suffit de préciser les paramètres à optimiser et à formuler la fonction coût à minimiser. Tout le reste est automatique, ce qui comprend une différentiation de la matrice tangente! Et aussi une recherche linéaire remplacée par une recherche sur un arc parabolique osculateur de la courbe d’état.

Cas d’étude et convergence

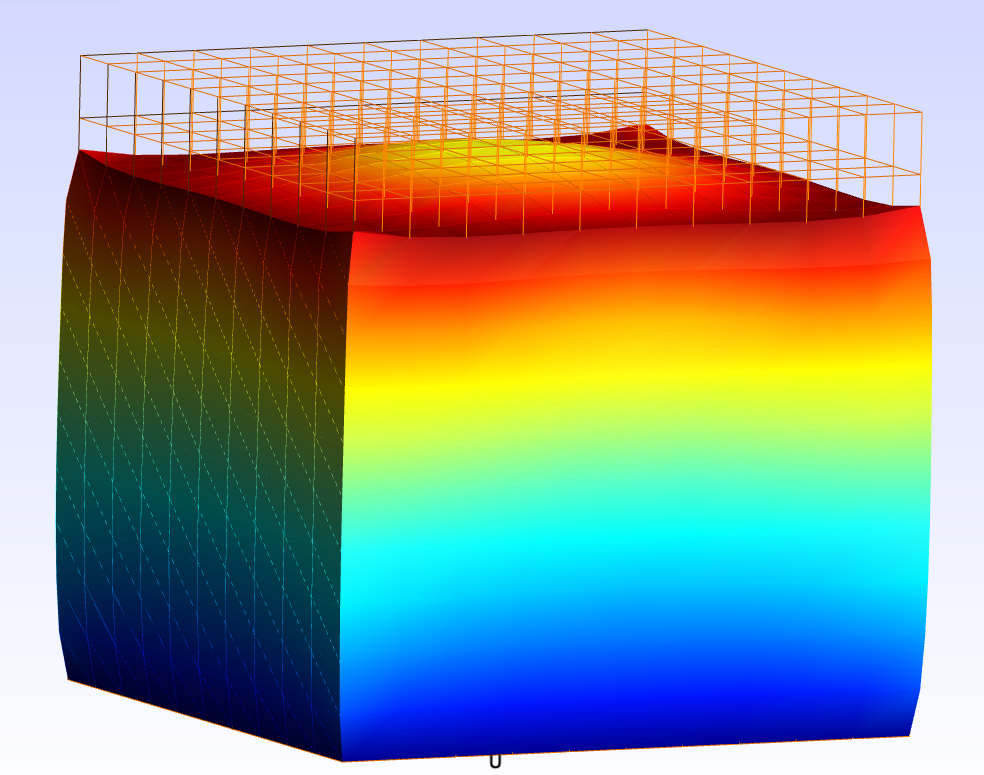

Le cas montré était tiré de l’élasticité non-linéaire avec comme paramètres les deux coefficients du polynôme donnant les déplacements imposés sur une face.

Exemple judicieusement choisi (ah! le hasard) car il illustre une conséquence d’un mauvais conditionnement: la direction de descente estimée par la hessienne quasiment orthogonale au gradient. Le gain en itérations est colossal par rapport à une méthode de plus grande pente.

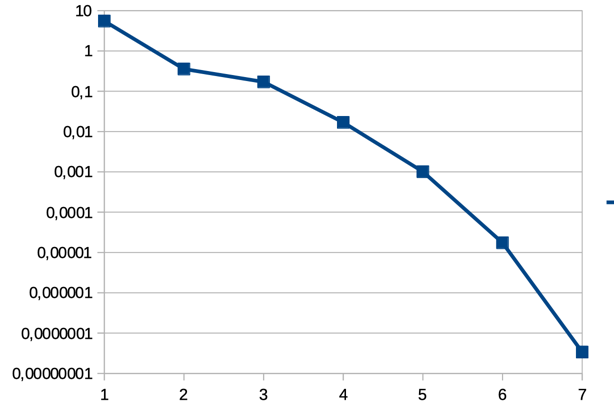

La convergence du résidu du gradient dans l’espace des paramètres est très rapide. Il s’agit d’un cas favorable: un problème inverse où la fonction coût mesure l’écart sur des résultats avec ceux de paramètres cibles. Ce type de cas valide a posteriori le calcul des dérivées.